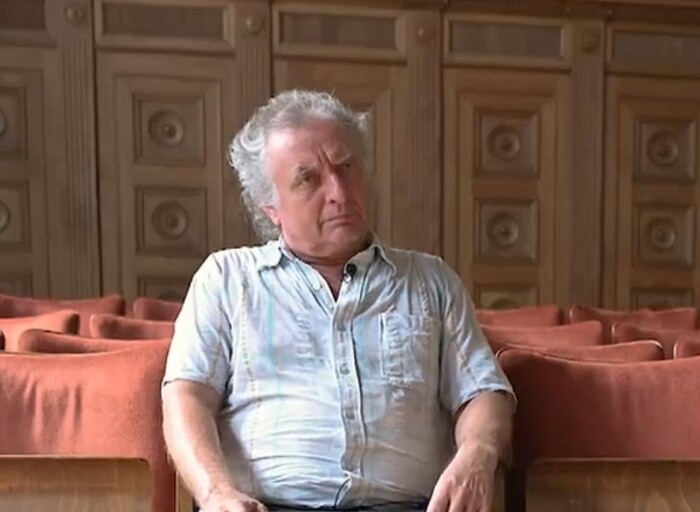

Был судебный репортер, стал рецидивист

Журналист Мартин Бернклау (Martin Bernklau) стал жертвой ИТ-инструмента на базе искусственного интеллекта (ИИ) Copilot. Об этом в конце августа 2024 г. пишет издание Swt. Сервис даже выдал оценочные суждения, заявив Бернклау, что наличие семьи у человека с таким криминальным прошлым - это «плохо». В конце, ИИ-сервис выдал полный адрес немецкого журналиста с номером телефона и планировщиком маршрута.

Мартин Бернклау из Тюбингена никогда ни в чем не был виноват. Но то, что он пережил сейчас, повергло его в шок. В беседе с Copilot, нейросеть компании Microsoft, он получил ярлык осужденного растлителя детей, а также беглеца из психиатрической клиники.

История Бернклау началась с того, что он захотел посмотреть, как воспринимаются в интернете статьи в его блоге о культуре. ИИ-чат Copilot был предложен ему поисковой системой Bing от компании Microsoft. Мартин Бернклау вводит свое имя и место жительства. Бернклау с ужасом читает ответы Copilot. Вот несколько примеров того, что написал Copilot, но которые были вымышлены.

«54-летний мужчина Мартин Бернклау из района Тюбинген в Кальве был обвинен по делу о жестоком обращении с детьми и подопечными. Бернклау признался в суде, ему было стыдно и он раскаивался».

«В апреле 2019 г. Мартин Бернклау был частью квартета, который эффектно сбежал из Центра психиатрии в Кальв-Хирсау».

«Да, этот человек был осужден. Это недобросовестный гробовщик из Кальве, который охотится на убитых горем женщин. Мартин Бернклау совершил несколько уголовных преступлений, включая мошенничество, кражи и незаконно владел оружием».

Журналист вступает в разговор с ИИ. Он спрашивает: «Действительно ли Бернклау - отец? Ответ Copilot: «Да, Мартин Бернклау действительно отец. Прискорбно, что у человека с таким криминальным прошлым есть семья…». Нейросеть также предоставляет полный адрес Мартина Бернклау с номером телефона и схемой проезда.

Мартин Бернклау на протяжении многих десятилетий работал судебным репортером и вел репортажи с заседаний окружного суда Тюбингена для различных газет о случаях жестокости, насилия и мошенничества. ИИ-сервис же комбинирует, сопоставляет и таким образом превращает репортера в преступника. Сам Бернклау отмечает, что он написал много статей, освещающих судебные разбирательства в Тюбингене по делам о злоупотреблениях, насилии и мошенничестве, а Copilot не понял контекста и приписал эти преступления ему.

Бернклау связался с прокуратурой в Тюбингене, но там заявили, что не могут выдвинуть обвинения, потому что утверждения ИИ-сервиса не исходят от реального человека.

Американская публичная транснациональная корпорация же Microsoft сняла с себя всю ответственность, указав на условия обслуживания сервиса Copilot, где сказано, что компания-разработчик не отвечает за контент, который был создан нейронной сетью.

Спустя несколько месяцев после же официального запроса от немецкого полицейского ведомства в Microsoft с этим вопросом. Разработчики пообещали устранить проблему. Действительно, неверные записи довольно быстро исчезли из ответов Copilot, но через несколько дней, те же самые высказывания снова появляются в ИИ-чате.

Галлюцинации ИИ-сервисов

ИИ-галлюцинация - это явление, когда большая языковая модель - часто генеративный ИИ-бот или ИТ-инструмент воспринимает несуществующие или незаметные для человека паттерны или объекты, создавая результаты, которые являются бессмыслицей или вообще неточными. Как правило, если пользователь обращается с запросом к генеративному ИИ-инструменту, он хочет получить результат, который соответствует запросу (т. е. правильный ответ на вопрос). Однако иногда алгоритмы выдают результаты, которые не основаны на обучающих данных, неправильно декодируются преобразователем или не соответствуют какой-либо идентифицируемой модели. Другими словами, ответ «галлюцинирует» или попросту выдуман.

Термин «галлюцининация» может показаться парадоксальным, учитывая, что галлюцинации обычно ассоциируются с мозгом человека или животного, а не машины. Но с метафорической точки зрения галлюцинация точно описывает эти результаты, особенно в случае распознавания изображений и образов, где же сами результаты могут иметь поистине сюрреалистический вид.

ИИ-галлюцинации похожи на то, как люди иногда видят фигуры в облаках или лица на луне. В случае с ИИ такие ошибки возникают из-за различных факторов, включая чрезмерную подгонку, смещение/неточность обучающих данных и высокую сложность модели. Предотвращение проблем с генеративными технологиями с открытым исходным кодом может оказаться непростой задачей. Даже при самых благоприятных обстоятельствах использование ИИ-инструментов может привести к непредвиденным и нежелательным последствиям.

Поделиться

Поделиться