Какие простейшие головоломки не может решить ИИ и почему

Существует множество способов проверить уровень развития искусственного интеллекта — от оценки его способности к диалогу, понимания прочитанного до невероятно сложных задач по физике. Но тесты, которые чаще всего ставят ИИ в тупик , — это те, которые люди считают относительно легкими.

Да, нейросети все больше преуспевают в задачах, требующих высокого уровня человеческих знаний, это не означает, что они близки к достижению общего искусственного интеллекта (ОИИ, AGI). ОИИ подразумевает, что ИИ может принимать очень небольшое количество информации и использовать ее для обобщения и адаптации к совершенно новым ситуациям. Эта способность, лежащая в основе обучения человека, по-прежнему остается для ИИ довольно сложной.

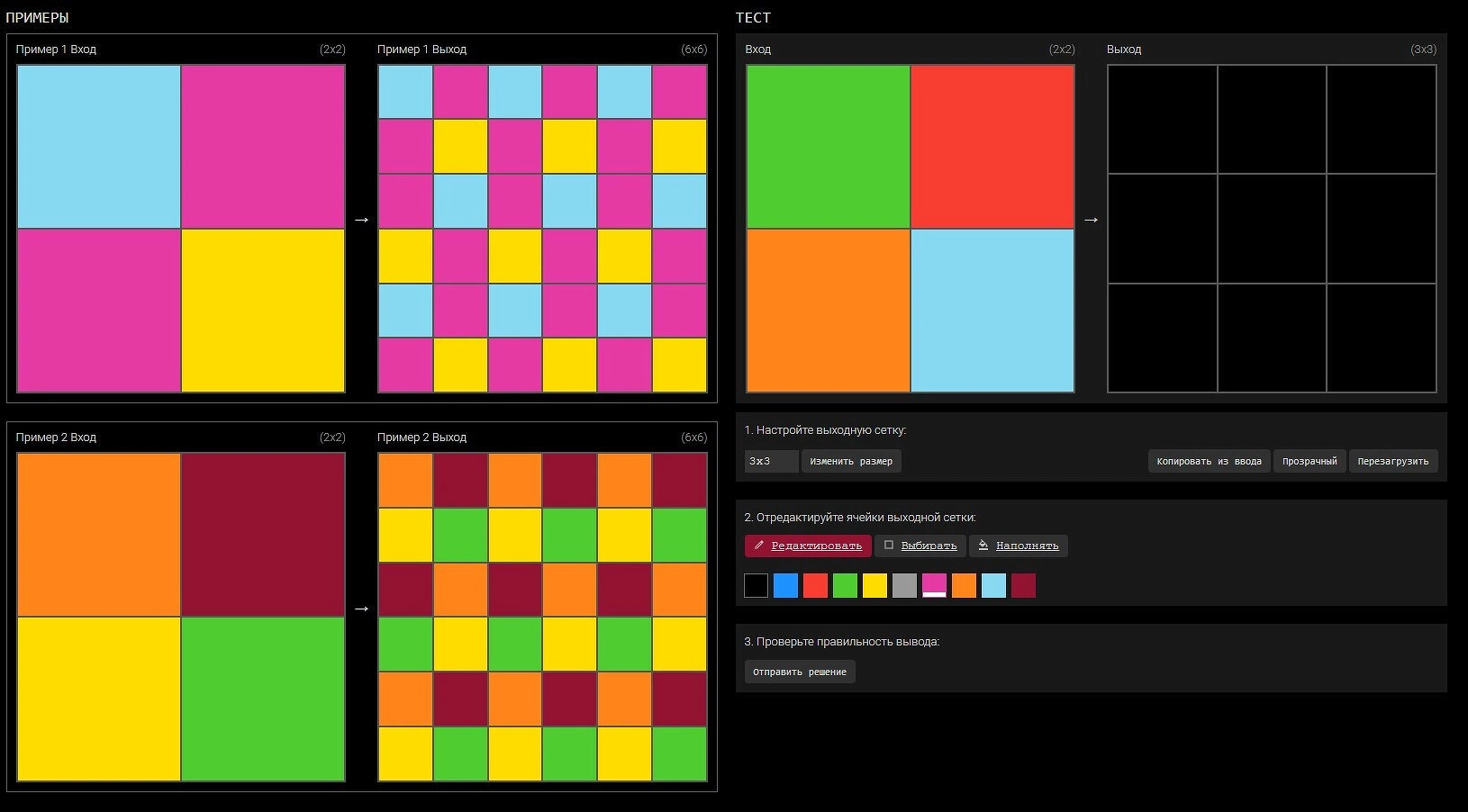

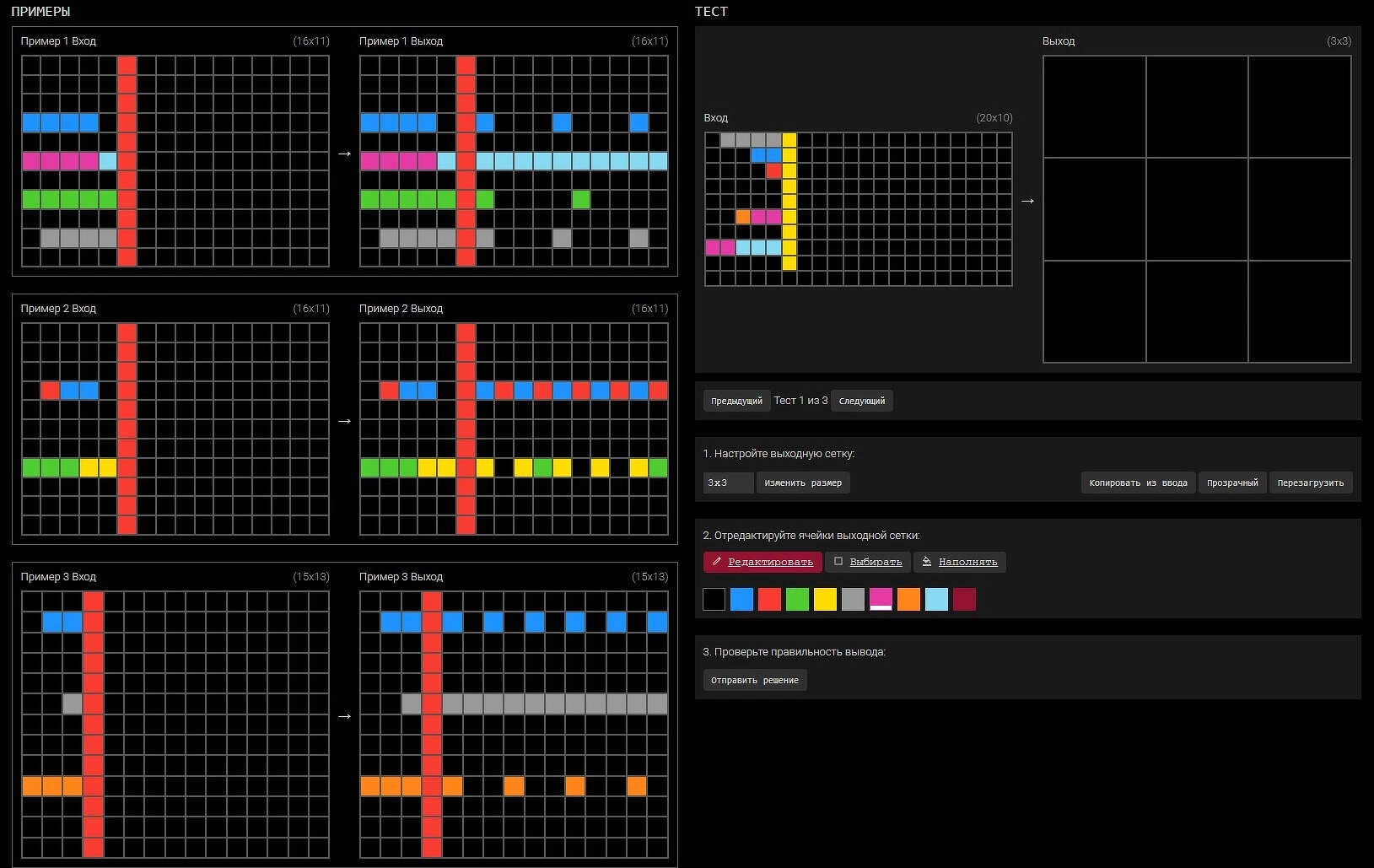

Одним из тестов, предназначенных для оценки способности ИИ к обобщению, является «Корпус абстракции и рассуждения» (ARC): набор небольших головоломок с сетками и цветными элементами, где решающему предлагается вывести скрытое правило и применить его к новой сетке.

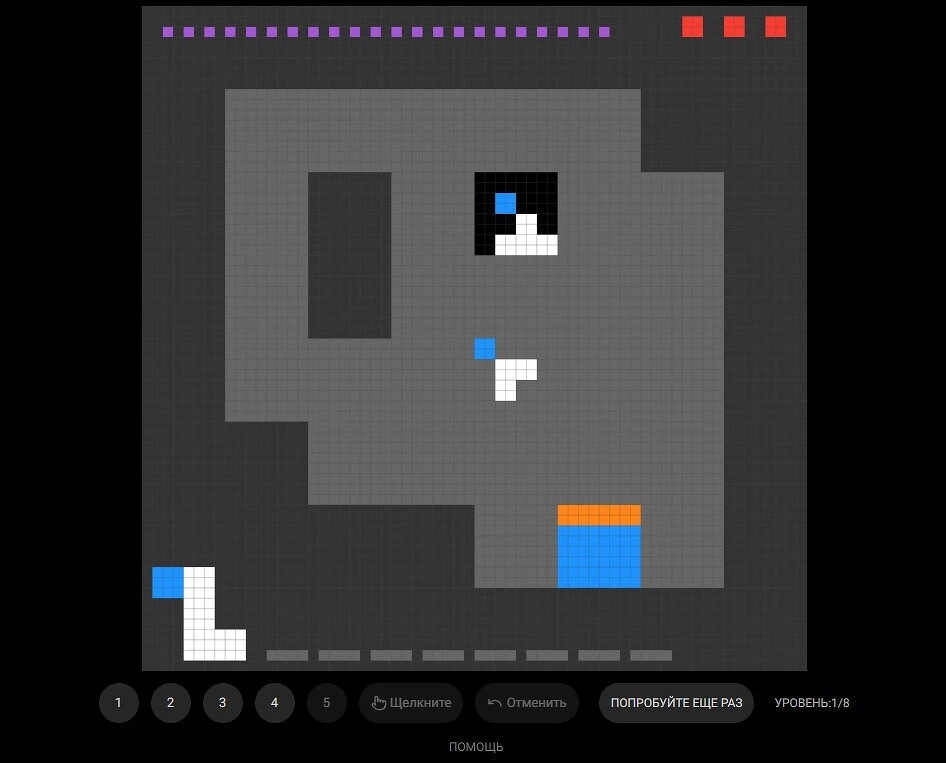

Разработанный исследователем ИИ Франсуа Шолле в 2019 году, тест стал отраслевым стандартом, используемым для всех основных моделей ИИ. Фонд ARC Prize Foundation — некоммерческая организация, которая проводит этот тест, — также разрабатывает новые тесты и регулярно использует два из них (ARC-AGI-1 и его более сложный преемник ARC-AGI-2). Также фонд запускает ARC-AGI-3 на базе видеоигр, специально разработанный для тестирования ИИ-агентов — программных систем, которые используют Al-алгоритмы для выполнения определенных задач без непосредственного участия человека.

Как эти тесты оценивают ИИ, что они говорят нам о потенциале искусственного интеллекта и почему они часто представляют сложность для моделей глубокого обучения, хотя многим людям кажутся относительно простыми?

Наш интеллект — это в том числе способность учиться новому. Мы уже знаем, что ИИ может выигрывать в шахматы и обыграть человека в го. Но эти модели не могут переносить свои умения на новые области — так, они не могут взять и выучить английский язык.

Поэтому был создан тест под названием ARC-AGI — он обучает какому-то мини-навыку в вопросе, а затем просит продемонстрировать этот мини-навык. По сути, вас чему-то учат и просят повторить навык, который вы только что изучили. Таким образом, тест измеряет способность модели обучаться в узкой области.

Главное требование к таким тестам — чтобы их могли решить люди. Фактически исследователи протестировали 400 человек на ARC-AGI-2. Их собрали в одной комнате, дали им компьютеры, провели демографический скрининг, а затем предложили пройти тест. Средний балл по ARC-AGI-2 составил 66%.

Что делает эти головоломки сложными для ИИ и относительно простыми для людей? Люди очень эффективно обучаются на основе выборок, то есть они могут взять задачу, всего на одном-двух примерах освоить мини-навык или преобразование и сразу же приступить к его реализации. Алгоритм, работающий в голове человека, на порядок лучше и эффективнее того, что сейчас имеется у ИИ.

В 2019 году был создан ARC-AGI-1, там было около 1000 задач. Когда модели OpenAI, появившиеся в 2024 году, продемонстрировали пошаговое изменение в возможностях ИИ, исследователи перешли к ARC-AGI-2. Правила там сложнее, а сетки крупнее, поэтому ответ должен быть точнее, но концепция примерно та же. Сейчас запущена пробная версия ARC-AGI-3, которая будет фактически интерактивной.

Если задуматься о реалиях повседневной жизни, то редко происходит так, что решение принимается без учета состояния. А все тесты для ИИ проводятся как раз без учета состояния. Если задать вопрос языковой модели, она даст один ответ. Многое невозможно проверить с помощью теста без учета состояния: планирование, исследование, интуицию относительно окружающей среды или целей, которые с ней связаны. Поэтому для теста используется 100 новых видеоигр, которые сначала задействуют для тестирования людей, а затем — моделей искусственного интеллекта.

Каждая «среда», или видеоигра, представляет собой двумерную пиксельную головоломку. Эти игры структурированы как отдельные уровни, каждый из которых предназначен для обучения игрока (человека или ИИ) определенному мини-навыку. Чтобы успешно пройти уровень, игрок должен продемонстрировать мастерское владение этим навыком, выполняя запланированную последовательность действий.

Исследователи ИИ считают: пока человечество находит задачи, которые могут решать люди, но не может ИИ — у нас нет ИИ. Один из ключевых факторов тестов, о которых идет речь, заключается в том, что с их помощью проверяют человека — и среднестатистический человек может справиться с этими задачами, а вот ИИ все еще испытывает с ними серьезные трудности. Интересно то, что некоторые продвинутые модели ИИ уже могут сдать любой экзамен на уровне выпускника, однако не обладают способностью к обобщению, как человек. И именно это демонстрируют описанные выше тесты.

Поделиться

Поделиться