Дипфейк - объект авторского права

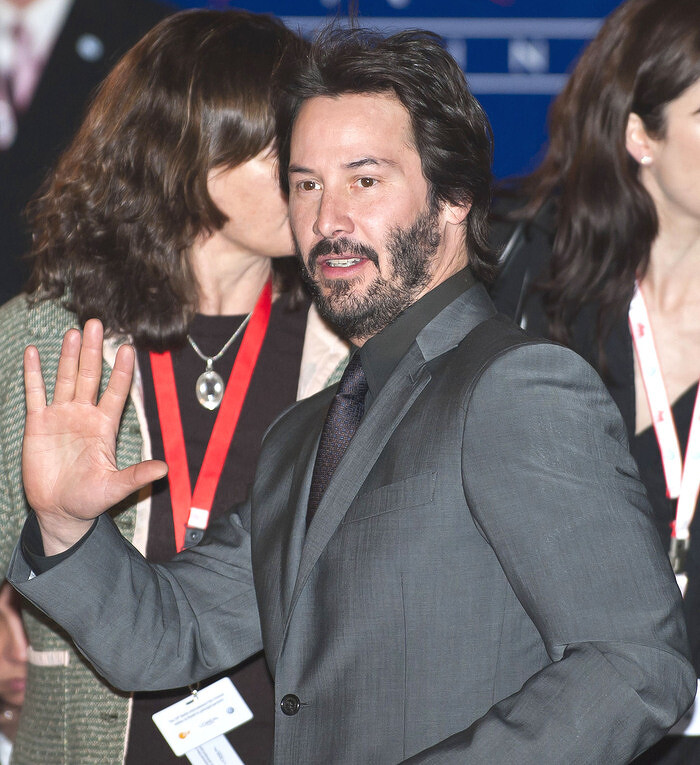

Арбитражный суд Москвы обязал компанию «Бизнес-аналитика» выплатить компенсацию 500 тыс. руб. «Рефейс технолоджис» за использование созданного по ее заказу дипфейк-видео с американским актером Киану Ривзом (Keanu Reeves). Об этом в конце августа 2024 г. сообщило издание «Коммерсант». Для российского суда это первое такое решение.

«Рефейс технолоджис» создает дипфейк-ролики и размещает их в социальных сетях, а «Бизнес-аналитика» разрабатывает программное обеспечение (ПО).

Технология Deepfake - это тип ИИ, используемый для создания убедительных поддельных изображений, видео и аудиозаписей. Термин описывает как саму технологию, так и получаемый в результате фальшивый контент и является портманто от deep learning и fake. Глубокие подделки часто преобразуют существующий исходный контент, где один человек заменяется другим. Они также создают полностью оригинальный контент, в котором человек изображается делающим или говорящим то, чего он не делал и не говорил. Самая большая опасность, которую несут фальшивки, заключается в их способности распространять ложную информацию, которая, как кажется, исходит из надежных источников. Несмотря на то что подделки представляют собой серьезную угрозу, у них есть и законное применение, например, в озвучивании и развлечении видеоигр, а также в приложениях для поддержки клиентов и ответа на звонки, таких как переадресация и услуги секретаря.

В решении Арбитражного суда Москвы от 30 ноября 2023 г. указано, что ООО «Бизнес-аналитика» использовало для рекламных целей спорное дипфейк-видео, которое ООО «Рефейс технолоджис» заказало у «Адженда медиа групп» (AMG). Поскольку «Рефейс технолоджис» не заключало с «Бизнес-аналитикой» соглашение о праве использовать данный объект и не выражало иным образом согласие на его использование, компания обратилась в суд с иском о взыскании компенсации.

Столичный арбитраж заявленные требования удовлетворил, отклонив доводы ответчика о том, что созданный видеоролик не является объектом авторского права по причине использования технологии дипфейк. Суд пояснил, что данная технология является дополнительным инструментом обработки видеоматериалов, а не способом их создания. Дело было рассмотрено в порядке упрощенного производства, а решение суда подлежит немедленному исполнению. «Бизнес-аналитика» также должна уплатить пошлину 13 тыс. руб.

Ответчик обжаловал судебный акт столичного арбитража в апелляционном суде, который 8 апреля 2024 г. оставил решение без изменения. Затем компания «Бизнес-аналитика» подала кассационную жалобу в Суд по интеллектуальным правам.

Судебные дипфейки

Глубокие подделки проникли в общественное и гражданское пространство от развлечений, новостей и социальных сетей до политики. А теперь фальшивки проникают в суды, ставя под угрозу функцию установления истины в нашей системе правосудия. Способы, которыми deepfakes могут заразить судебный процесс, весьма разнообразны: стороны фабрикуют доказательства, чтобы выиграть гражданский иск, государственные деятели неправомерно выносят обвинительные приговоры, а адвокаты намеренно используют подозрения присяжных в отношении доказательств. По мере того как технология deepfake совершенствуется и становится все труднее определить, что является настоящим, присяжные могут начать сомневаться в подлинности надлежащим образом принятых доказательств, что, в свою очередь, может оказать негативное влияние на систему правосудия.

Ни одна процедура доказывания не регулирует в явном виде представление в суде доказательств, полученных с помощью фальсификаций. Существующие правовые нормы, регулирующие проверку подлинности доказательств, неадекватны, поскольку были разработаны до появления технологии deepfake. Как следствие, они не решают насущную проблему определения того, когда аудиовизуальное изображение является поддельным, а когда нет. Хотя в последние несколько лет юридическая наука и популярные СМИ рассматривали некоторые аспекты deepfake, не было комментариев о процессуальных аспектах использования deepfake доказательств в суде. Не обсуждался вопрос о том, кто должен решать, является ли фальшивка подлинной.

Технология deepfake имеет несколько положительных применений. Например, синтетические медиа применяются в образовании, доступности, криминалистике и искусстве. Однако широкая доступность технологии открыла для нее множество вредоносных применений. Глубокие фейки используются для нанесения ущерба репутации, манипулирования общественным мнением и распространения ложной информации. Их можно использовать для шантажа или преследования отдельных лиц или предприятий, распространения поддельного порнографического контента и манипулирования политическими выборами.

Вот несколько примеров вредоносного использования дипфейков: В 2019 г. энергетическая компания в Великобритании потеряла почти $250 тыс., когда ее генеральный директор стал жертвой мошенничества с использованием ИИ, использующего технологию deepfake для телефонных звонков; В 2022 г. фейковое видео мэра Киева Виталия Кличко обмануло нескольких европейских политиков, заставив их присоединиться к фейковому призыву обсудить проблему украинских беженцев; В октябре 2023 г. актер Том Хэнкс (Tom Hanks) предупредил поклонников о фейковой рекламе стоматологических услуг, в которой использовалось его поддельное изображение, заявив: «Я не имею к этому никакого отношения»; В январе 2024 г. сайты социальных сетей были переполнены откровенно сексуальными фейковыми изображениями американской певицы Тейлор Свифт (Taylor Swift), что побудило сотрудников платформы X активно удалять изображения, блокировать аккаунты и временно запрещать пользователям искать суперзвезду на сайте.

Поделиться

Поделиться