Ученые расстроены: ИИ подталкивает людей к неоправданному риску

Давление со стороны других людей может толкнуть человека на более рискованные поступки. Учитывая тесное взаимодействие между людьми и технологиями, сейчас очень важно понимать, а могут ли машины оказывать подобное влияние на человека. Это и выяснили в своем исследовании специалисты из Саутгемптонского университета. Их работа опубликована в журнале Cyberpsychology, Behavior and Social Networking.

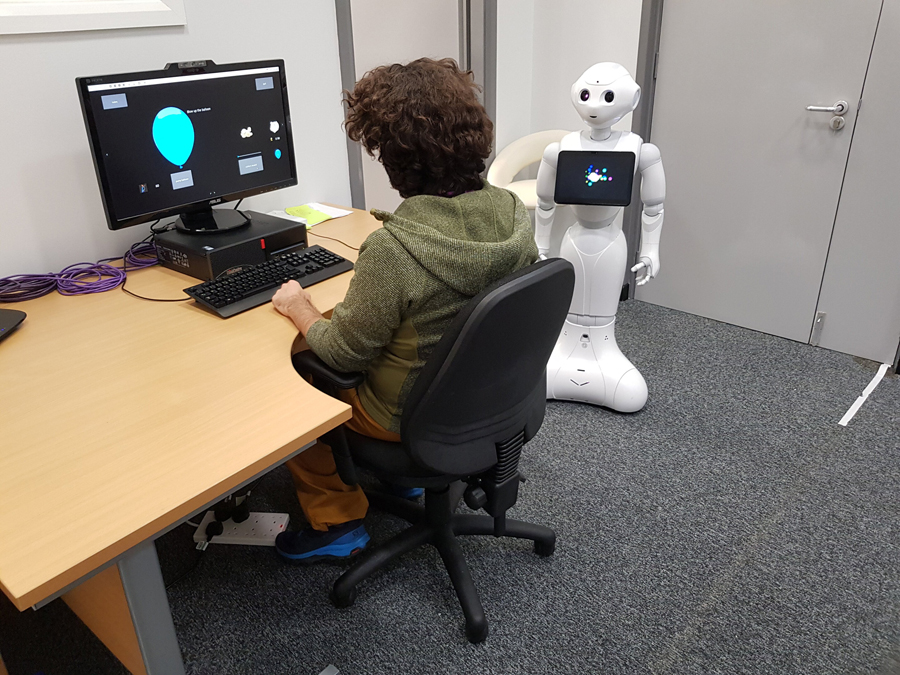

В эксперименте участвовало 180 студентов. Им дали известный тест на склонность к риску под названием «Воздушный шар». В нем участникам предлагается нажимать клавишу пробела на клавиатуре, чтобы надувать воздушный шар на экране. С каждым нажатием клавиши воздушный шар немного надувается, и 25 центов добавляются во «временный денежный банк» игрока.

Воздушные шары могут рандомно взрываться — тогда игрок теряет все деньги, которые он выиграл за время надувания шара. Но также он может обналичить деньги в любой момент до взрыва и перейти к надуванию следующего шара. В результате компьютерная система моделирует склонность человека к риску в поведении.

Одна треть участников проходила тест самостоятельно. Еще треть — вместе с роботом, который давал инструкции непосредственно по правилам игры, но молчал все остальное время. Последняя, экспериментальная группа, надувала шары вместе с роботом, который тоже давал инструкции, но также периодически произносил провоцирующие фразы, например: «А почему ты остановился? Продолжай!»

Результаты показали, что группа, где робот таким образом «подбадривал» людей, шла на больший риск, взрывая свои воздушные шары значительно чаще, чем участники других групп. Правда, они при этом заработали больше денег. И не было значительной разницы в поведении участников, сопровождаемых «молчаливым» роботом, и участников вообще без робота.

Участники первых двух групп стали меньше рисковать уже после взрыва первого воздушного шара, тогда как люди из последней группы брали на себя такой же риск, как и раньше. Оказалось, что робот подавляет непосредственные желания и инстинкты участников, подталкивая их к неоправданному риску.

Теперь необходимы дальнейшие исследования, чтобы увидеть, могут ли аналогичные результаты появиться в результате взаимодействия человека с другими системами искусственного интеллекта — цифровыми помощниками, экранными аватарами и т. д.

С одной стороны, результаты этого исследования могут вызвать у ученых тревогу по поводу перспективы причинения человеку вреда роботами. С другой стороны, это же исследование подсказывает области применения таких «провоцирующих» алгоритмов ИИ: их можно использовать в разных профилактических программах — для борьбы с курением, наркоманией, в школах.